软件所提出一种新型时间序列预测框架

文章来源: | 发布时间:2026-01-27 | 【打印】 【关闭】

中国科学院软件研究所天基综合信息系统全国重点实验室研究团队为提升大语言模型时间序列预测性能,提出一种向量注入式上下文学习框架。该框架在稳定提升时间序列预测性能的同时,还能显著降低计算开销。相关成果论文Enhancing Large Language Models for Time-Series Forecasting via Vector-Injected In-Context Learning被互联网领域顶级国际学术会议The Web Conference 2026(WWW-26)录用,共同第一作者为博士生张健琦、博士生王婧瑶,通讯作者为副研究员强文文。

大语言模型进行时间序列预测时面临一项主要挑战:预训练文本与时间序列数据在分布与结构上存在显著差异。传统方法通常采用全量微调来减少这种差异,但其训练成本高、显存占用大,限制了实际应用。

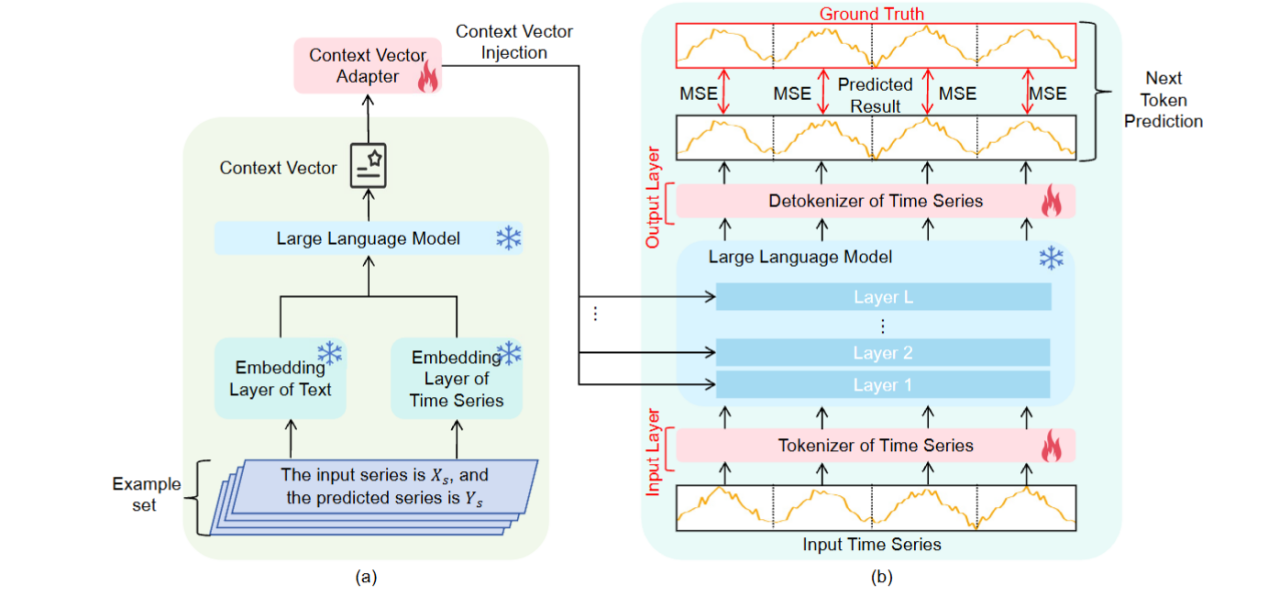

为解决这一问题,研究团队提出一种引入上下文学习的方法Vector-Injected In-Context Learning(LVICL)。该方法通过在输入提示中引入任务示例,使模型无需更新参数即可实现“类似微调”的效果。为提升上下文学习对示例选择与顺序敏感的不稳定问题,该方法首先提取示例的向量表示,并以置换不变的方法进行聚合,从而消除顺序敏感性。随后,采用轻量适配器对聚合后的上下文向量进行精练,抑制其中可能干扰预测的分量,增强对示例选择的鲁棒性。最后,将优化后的向量注入到大语言模型各层的残差流中,以可控方式引导模型进行预测。

LVICL的总体框架

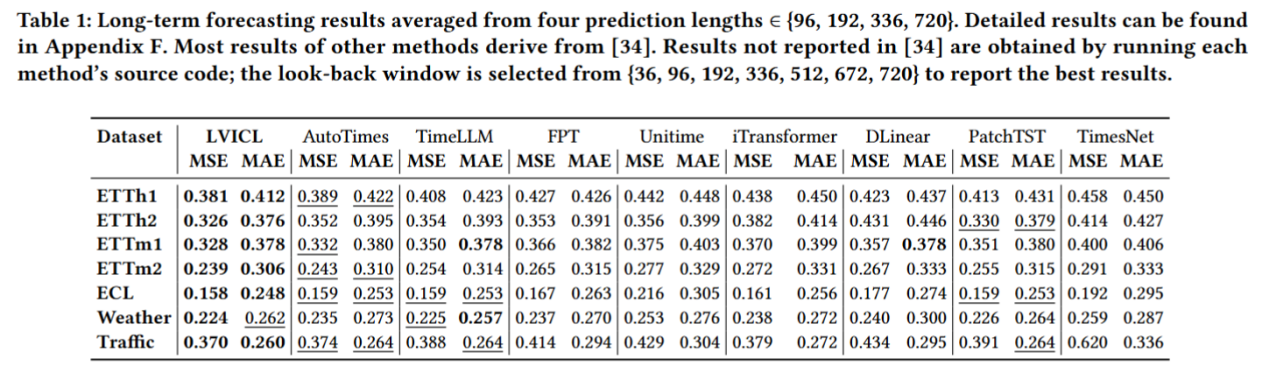

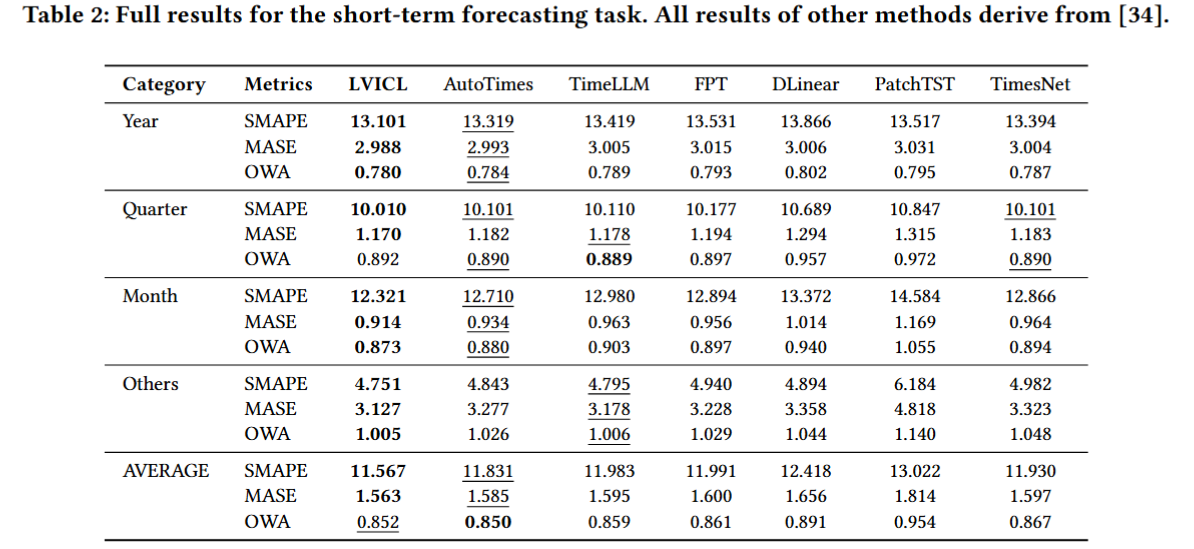

研究团队在多个时间序列预测基准数据集上对LVICL进行了系统评估。实验表明,LVICL在保持 LLM 完全冻结、训练开销显著降低的前提下,能够稳定复现并进一步放大上下文学习带来的收益。与轻量微调方法相比,LVICL在多种数据集与实验设置下均表现出更强的预测能力,并在效率与性能的平衡上展现出更好的实用性。

长期预测结果

短期预测结果